Apache Kafka — это популярная и масштабируемая платформа для обработки данных в реальном времени. Она используется множеством компаний для передачи данных между различными компонентами системы. В этой статье мы рассмотрим, как создавать и использовать пользовательский сериализатор в Kafka.

Пользовательский сериализатор в Kafka: особенности создания с примерами кода

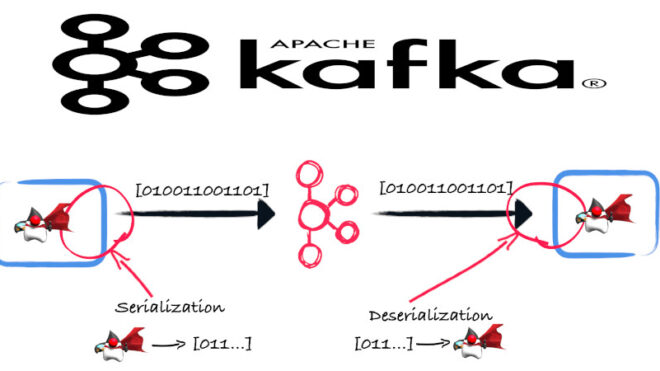

Сериализация — это процесс преобразования объектов в байтовый формат, который может быть легко передан через сеть или сохранен в файле. В контексте Kafka, сериализация используется для преобразования данных, которые вы хотите отправить в топик, в байтовый массив перед их публикацией. Десериализация, с другой стороны, выполняет обратное преобразование, преобразуя байты обратно в объекты при чтении данных из топика.

Пользовательский сериализатор (user serializer) представляет собой набор функций, создаваемых пользователем с целью осуществления сериализации, то есть преобразования объектов в байтовые массивы, для объектов, которые ему необходимы. Kafka предоставляет несколько встроенных сериализаторов, таких как StringSerializer, IntegerSerializer, ByteArraySerializer и другие, для обработки общих типов данных. Однако, если ваши данные представлены сложными объектами, вы можете создать свой собственный пользовательский сериализатор.

Для создания пользовательского сериализатора вам нужно реализовать интерфейс org.apache.kafka.common.serialization.Serializer. Этот интерфейс требует реализации метода serialize, который принимает на входе топик и объект для сериализации и возвращает байтовый массив [1]:

import org.apache.kafka.common.serialization.Serializer;

import java.util.Map;

public class PersonSerializer implements Serializer<Person> {

@Override

public void configure(Map<String, ?> configs, boolean isKey) {

// Настройка сериализатора, если необходимо

}

@Override

public byte[] serialize(String topic, Person person) {

if (person == null) {

return null;

}

try {

// Преобразование объекта Person в байтовый массив

return person.toString().getBytes("UTF-8");

} catch (Exception e) {

throw new RuntimeException("Ошибка сериализации объекта Person", e);

}

}

@Override

public void close() {

// Освободить ресурсы, если это необходимо

}

}

После создания пользовательского сериализатора вы можете использовать его при создании Kafka Producer. Вот пример того, как это можно сделать [2]:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerConfig;

import java.util.Properties;

public class ProducerExample {

public static void main(String[] args) {

Properties props = new Properties();

props.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

props.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

props.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "com.example.PersonSerializer"); // Используем наш пользовательский сериализатор

Producer<String, Person> producer = new KafkaProducer<>(props);

// Отправка сообщения в топик

Person person = new Person("Иван", 30);

producer.send(new ProducerRecord<>("my-topic", "key", person));

producer.close();

}

}

В этом примере мы указываем пользовательский сериализатор com.example.PersonSerializer для значения сообщения. После этого мы можем отправить объекты типа Person в топик my-topic.

Таким образом, пользовательские сериализаторы в Apache Kafka позволяют работать с более сложными типами данных, которые не могут быть обработаны стандартными сериализаторами.

Это делает Apache Kafka универсальным и надежным средством для хранения и обмена большими потоками данных, что позволяет активно использовать этот брокер сообщений в задачах Data Science и разработке распределенных приложений. В следующей статье мы поговорим про получение записей с заданными смещениями в Kafka.

Apache Kafka для инженеров данных

Код курса

DEVKI

Ближайшая дата курса

8 сентября, 2025

Продолжительность

24 ак.часов

Стоимость обучения

72 000 руб.

Освоить Apache Kafka на профессиональном уровне в качестве администратора Big Data кластеров, разработчика распределенных приложений и прочих прикладных областях Data Science вы сможете на практических курсах по Kafka в нашем лицензированном учебном центре обучения и повышения квалификации ИТ-специалистов в Москве:

- Администрирование кластера Kafka

- Apache Kafka для разработчиков

- Администрирование кластера Arenadata Streaming Kafka

Источники

- https://kafka.apache.org/documentation/

- Н.Нархид, Г.Шапира, Т.Палино. Apache Kafka. Потоковая обработка и анализ данных