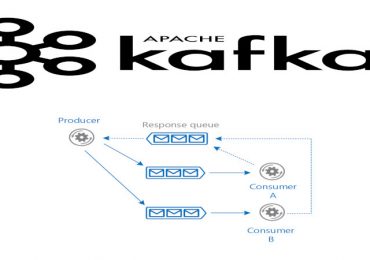

Apache Kafka является мощным инструментом для обработки данных в реальном времени. Однако, интеграция Kafka с различными источниками данных и приемниками может быть задачей, требующей значительных усилий. Здесь на помощь приходит Kafka Connect — расширение Kafka, предназначенное для облегчения интеграции с внешними системами. В этой статье мы рассмотрим основные концепции Kafka Connect.

Особенности работы с Kafka Connect: несколько практических примеров

Kafka Connect — это фреймворк для интеграции данных, который позволяет легко подключать и передавать данные между Kafka и внешними системами. Он построен на архитектуре producer-consumer, используя коннекторы для определения способа передачи данных. Коннекторы Kafka Connect делятся на два типа: Source (источник) и Sink (приемник). Source-коннекторы используются для передачи данных из внешних источников в Kafka, а Sink-коннекторы — для передачи данных из Kafka во внешние системы. Рассмотрим пример Source-коннектора, который передает данные из файла в тему Kafka. Для этого создадим текстовый файл source-data.txt с несколькими строками текста [1]:

import org.apache.kafka.connect.source.SourceConnector;

import org.apache.kafka.connect.source.SourceRecord;

import java.io.BufferedReader;

import java.io.FileReader;

import java.util.ArrayList;

import java.util.List;

import java.util.Map;

public class FileSourceConnector extends SourceConnector {

private String filename;

@Override

public void start(Map<String, String> props) {

filename = props.get("source-data.txt");

}

@Override

public Class<? extends Task> taskClass() {

return FileSourceTask.class;

}

@Override

public List<Map<String, String>> taskConfigs(int maxTasks) {

List<Map<String, String>> configs = new ArrayList<>();

Map<String, String> config = new HashMap<>();

config.put("filename", filename);

configs.add(config);

return configs;

}

@Override

public void stop() {

// Освобождение ресурсов

}

@Override

public ConfigDef config() {

return new ConfigDef();

}

@Override

public String version() {

return "1.0";

}

}

В данном коде FileSourceConnector предоставляет конфигурацию, включая имя файла, и создает экземпляр FileSourceTask, который фактически выполняет чтение данных и передачу их в Kafka.

Теперь рассмотрим пример Sink-коннектора, который записывает данные из темы Kafka в текстовый файл [1]:

import org.apache.kafka.connect.sink.SinkRecord;

import org.apache.kafka.connect.sink.SinkTask;

import java.io.FileWriter;

import java.io.IOException;

import java.util.Collection;

import java.util.Map;

public class FileSinkTask extends SinkTask {

private String filename;

@Override

public void start(Map<String, String> props) {

filename = props.get("out-data.txt");

}

@Override

public void put(Collection<SinkRecord> records) {

try (FileWriter writer = new FileWriter(filename, true)) {

for (SinkRecord record : records) {

writer.write(record.value().toString() + "\n");

}

} catch (IOException e) {

e.printStackTrace();

}

}

@Override

public void stop() {

// Освобождение ресурсов

}

@Override

public String version() {

return "1.0";

}

}

В данном примере FileSinkTask получает записи из темы Kafka и записывает их в указанный файл.

Таким образом, с использованием инструмента Kafka Connect у брокера Apache Kafka появляется возможность эффективной загрузки данных из различных хранилищ больших объемов информации, включая облачные хранилища, такие как Amazon AWS, Dropbox и iCloud. Эта утилита придает Apache Kafka универсальные возможности для хранения и передачи обширных потоков данных, что делает его востребованным инструментом в области Data Science и разработки распределенных приложений.

Освоить Apache Kafka на профессиональном уровне в качестве администратора Big Data кластеров, разработчика распределенных приложений и прочих прикладных областях Data Science вы сможете на практических курсах по Kafka в нашем лицензированном учебном центре обучения и повышения квалификации ИТ-специалистов в Москве:

- Администрирование кластера Kafka

- Apache Kafka для разработчиков

- Администрирование кластера Arenadata Streaming Kafka

Источники

- Н.Нархид, Г.Шапира, Т.Палино. Apache Kafka. Потоковая обработка и анализ данных